Stable Diffusion

Autor: Rainer Gievers (März 2025)

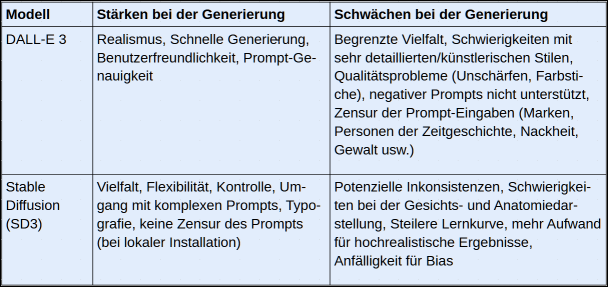

Neben DALL-E gehört Stable Diffusion1 zu den am häufigsten genutzten KI-Modellen für die Bildgenerierung. Das KI-Modell wurde von den Unternehmen Stability AI und Runway ML in Zusammenarbeit mit Forschern der Universität Heidelberg entwickelt.

Im Gegensatz zu DALL-E ist Stable Diffusion seit 2022 als Open-Source-Software frei verfügbar, kostenfrei nutzbar und kann in eigene Anwendungen integriert werden. Diese Offenheit hat es zu einer der führenden Technologien im Bereich generativer KI gemacht.

Ein Vergleich der Bildqualität mit DALL-E zeigt, dass Stable Diffusion standardmäßig zu eher fotorealistischen Bildern neigt, während DALL-E 3 tendenziell abstraktere oder computergenerierter wirkende Bilder erzeugt. Durch gezieltes Prompting lässt sich allerdings mit beiden KI-Modellen ein breites Spektrum an Stilen realisieren.

Die frei erhältlichen KI-Modelle von Stable Diffusion lassen sich mit eigenen Trainingsdaten an spezielle Anwendungsgebiete anpassen. Die damit verbundene Flexibilität hebt Stable Diffusion weit von der mit festen Modellen arbeitenden Konkurrenz ab.

Der größte Vorteil von Stable Diffusion ist die Möglichkeit, die Software lokal auf einem PC zu installieren. Dadurch entfallen im Vergleich zu Online-KI-Diensten die Kosten für die Bildgenerierung.

Es hat sich eine umfangreiche Community gebildet, die spezialisierte KI-Modelle für Stable Diffusion entwickelt hat und kostenlos verteilt. Diese Modelle sind auf spezifische Anwendungsbereiche wie Manga, hyperrealistische Porträts oder Videospielcharaktere trainiert.

Lokale Installation

Im Gegensatz zu Cloud-basierten Lösungen haben Sie bei der lokalen Installation von Stable Diffusion auf einem PC die vollständige Kontrolle: Sie können dann Stable Diffusion individuell anpassen, sind auf keine Internetverbindung angewiesen und müssen für die Generierung auch kein teures Abo abschließen2 3.

In diesem Kapitel geben wir Ihnen eine detaillierte Schritt-für-Schritt-Anleitung zur lokalen Installation von Stable Diffusion auf einem Windows-PC.

Im Folgen kürzen wir aus Effizienzgründen »Stable Diffusion« mit »SD« ab.

Hardware-Anforderungen

SD greift auf den Grafikkartenprozessor (GPU) zurück, welcher die nötigen Berechnungen wesentlich schneller durchführt als die CPU des PCs. Empfehlenswert ist dabei eine Nvidia-Grafikkarte der RTX-Serie mit mindestens 8 GB VRAM. Angepasste SD-Versionen für AMD-Grafikkarten gibt es zwar auch4, deren Installation ist aber komplizierter, weshalb wir auf diese nicht eingehen.

Die Tabelle zeigt die minimalen und empfohlenen Hardwareanforderungen:

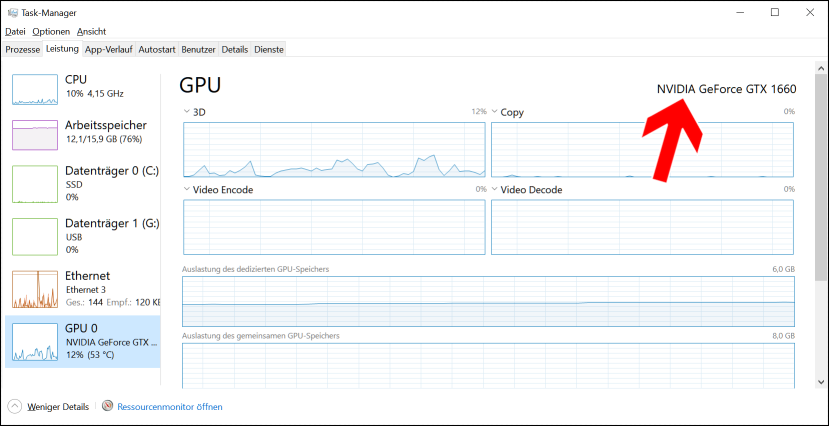

Bevor Sie sich die Mühe einer Installation machen, prüfen Sie bitte die in Ihrem PC verwendete Grafikkarte.

So finden Sie die Grafikkarte heraus:

- Drücken Sie Strg + Umschalttaste + Esc gleichzeitig, um den Task-Manager zu öffnen.

- Klicken Sie auf den Leistung-Reiter.

- Wählen Sie in der linken Spalte GPU aus.

- Der Name der Grafikkarte wird oben rechts angezeigt.

Auf diesem PC kommt eine NVDIA GeForce GTX 1660 mit 8 GB (wird unten rechts angezeigt) zum Einsatz.

Pauschal kann man sagen, dass SD mit jeder mehr oder weniger aktuellen NVDIA-Grafikkarte mit mindestens 8 GB funktioniert, wenn man längere Wartezeiten von bis zu 10 Minuten für die Bildgenerierung akzeptiert.

Folgende Grafikkarten sind derzeit (Stand: 10/2025) preislich interessant, falls Sie Ihren PC nachrüsten möchten:

- Nvidia RTX 3060 (12 GB VRAM) bietet für ca. 300 Euro das beste Preis-Leistungsverhältnis.

- Nvidia RTX 4060 Ti (16 GB VRAM): Ab ca. 1000 Euro

- Nvidia RTX 4070 (12 GB VRAM): Ab ca. 600 Euro

Beachten Sie vor dem Nachkauf einer Grafikkarte, dass deren Einbau eine gewisse Geschicklichkeit voraussetzt. Im Zusammenhang damit kann zusätzlich der Austausch des PC-Netzteils gegen ein leistungsfähigeres Modell nötig sein. Für die Nvidia RTX 3060 oder RX 4060 Ti sollte das Netzteil beispielsweise mindestens 600 bis 650 Watt leisten, mit 80+ Bronze oder besser zertifiziert sein und über die nötigen PCIe-Stromanschlüsse verfügen (8-Pin oder 6+2-Pin für die Grafikkarte).

Für dieses Buch haben wir unsere alte Nvidia GeForce GTX 1660 problemlos gegen eine GeForce RTX 3060 getauscht. Die für die Bildgenerierung benötigte Zeit ist damit von mehreren Minuten auf wenige Sekunden gesunken.

Installation

Als Betriebssystem wird ein 64-Bit-System mit Windows 10 oder 11 empfohlen5. Unter Windows 11 sind möglicherweise einige vorbereitende Prozesse automatisiert6. Fast alle in den letzten 10 Jahren verkaufen PCs laufen mit 64 Bit.

Während der Installation richten Sie mehrere verschiedene Softwarekomponenten ein, auf die wir aber noch eingehen. Genau genommen handelt es sich bei SD (Stable Diffusion) um zwei getrennte Komponenten: Einmal der »Server« im Hintergrund, der die eigentlichen Berechnungen durchführt, zum anderen eine Benutzeroberfläche, bei der wir uns für »AUTOMATIC1111 Web UI« entschieden haben.

Kernkomponenten einer SD-Installation sind »Git« für die automatische Aktualisierung von SD-Komponenten und die Programmiersprache »Python« für die Ausführung der Programme.

Stable Diffusion installieren

Besuchen Sie https://git-scm.com/downloads/win, um die 64-Bit-Version von Git herunterzuladen. Klicken Sie dafür einfach auf Click here to download und führen Sie die Datei aus. Bestätigen Sie während der Installation die vorgeschlagenen Standardoptionen.

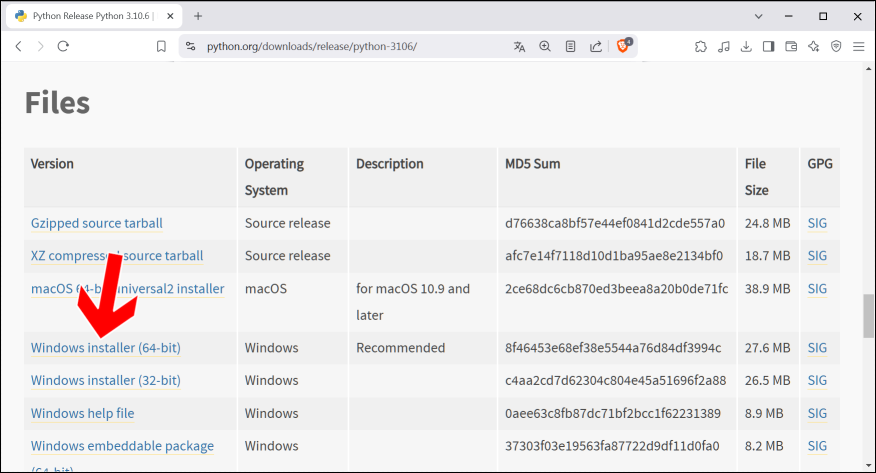

Ein weiterer wichtiger Softwarebestandteil ist Python. Für SD wird die Version 3.10.6 dringend empfohlen, da diese sich als die kompatibelste erwiesen hat. Neuere Versionen wie 3.11 oder höher sollten vorerst vermieden werden, da sie möglicherweise zu Kompatibilitätsproblemen führen können7. Python 3.10.6 kann von der offiziellen Python-Website unter https://www.python.org/downloads/release/python-3106 heruntergeladen werden. Blättern Sie durch die Seite bis zur Files-Sektion, wo Sie Windows Installer (64-Bit) zum Download anklicken. Installieren Sie dann das Programm.

Bei der Installation ist es entscheidend, die Option zu aktivieren, die python.exe zum Systempfad hinzufügt. Diese Option »Add Python 3.10 to PATH« (Pfeil) ermöglicht einen einfachen Zugriff auf Python über die Kommandozeile und verhindert Fehlermeldungen wie »Python not found«.

Obwohl eine alternative Installation über den Microsoft Store erwähnt wird, hat sich die Installation von der Website in der Regel als zuverlässiger erwiesen8. Nach der Installation kann die korrekte Installation von Python überprüft werden, indem die Eingabeaufforderung geöffnet und der Befehl python eingegeben wird -- Sie öffnen die Kommandozeile, indem Sie im Windows-Suchfeld einfach CMD eingeben und dann auf Eingabeaufforderung klicken. Die Ausgabe sollte »Python 3.10.6« anzeigen. Die Notwendigkeit der spezifischen Python-Version und die Aktivierung der »Add to PATH«-Option sind entscheidend für eine fehlerfreie Nutzung von SD!

Öffnen Sie den Datei-Explorer (Windows-Taste + E) und navigieren Sie zu einem Speicherort Ihrer Wahl, beispielsweise direkt auf dem C:-Laufwerk. Es wird empfohlen, den Programme-Ordner zu vermeiden. Erstellen Sie in dem gewählten Verzeichnis einen neuen Ordner mit dem Namen stable-diffusion. Wenn Sie unserer Anleitung problemlos folgen wollen, empfehlen wir Ihnen das Verzeichnis im Wurzelverzeichnis von C: anzulegen, sodass Sie es dann unter c:\stable-diffusion nutzen. Von der Verwendung eines externen Laufwerks oder eines USB-Sticks raten wir übrigens ab, denn Zugriffe sind darauf im Vergleich zur Festplatte extrem langsam, was die Bildgenerierung länger dauern lässt.

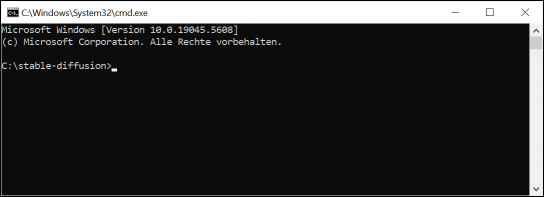

Im nächsten Schritt muss die Eingabeaufforderung (CMD) im erstellten Installationsordner geöffnet werden. Navigieren Sie hierzu in den Ordner stable-diffusion. Klicken Sie anschließend in die Adressleiste des Datei-Explorers und entfernen Sie mit der Entf- oder Löschen-Taste den angezeigten Dateipfad. Geben Sie CMD ein und drücken Sie die Eingabetaste. Falls Sie sich mit der Kommandozeile auskennen, können Sie natürlich einfach die CMD-Eingabeaufforderung, wie zuvor gezeigt, aufrufen und mit dem Befehl »cd \stable-diffusion« in das Verzeichnis wechseln.

So sollte die Eingabezeile aussehen, bevor Sie weiter fortfahren.

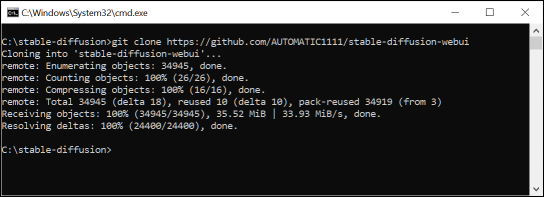

Der folgende Befehl kopiert das sogenannte Stable Diffusion WebUI Repository von GitHub auf Ihre Festplatte:

git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui

Die Verwendung von git clone ermöglicht zukünftige Aktualisierungen von Stable Diffusion auf einfache Weise.

Stable Diffusion in der Praxis

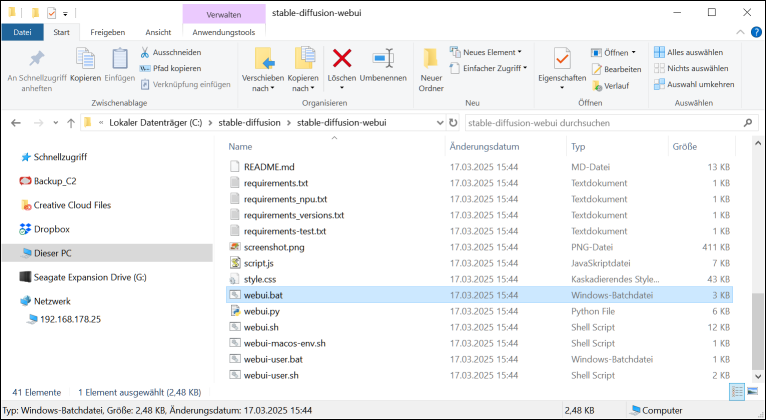

Starten Sie die SD-Weboberfläche durch einen Doppelklick auf webui.bat im Verzeichnis C:\stable-diffusion\stable-diffusion-webui.

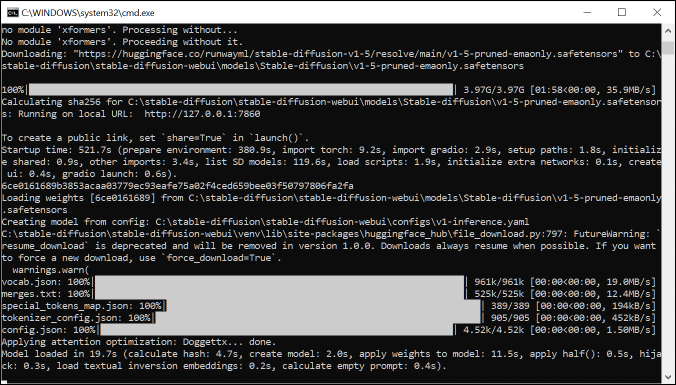

Es öffnet sich zunächst eine Eingabeaufforderung. Das Herunterladen und die Installation der notwendigen Pakete, die für SD erforderlich sind, kann beim ersten Aufruf bis zu einer Viertelstunde in Anspruch nehmen.

Im Normalfall startet danach automatisch Ihr Webbrowser und lädt eine lokale Netzwerkadresse, zum Beispiel

http://127.0.0.1:7860

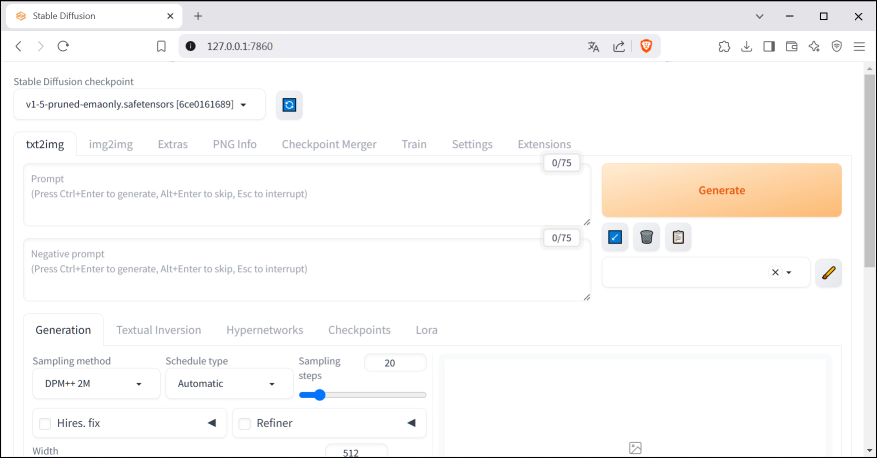

Die SD-Weboberfläche wird angezeigt. Erstellen Sie davon ein Lesezeichen in Ihrem Browser für den erneuten Aufruf, falls Sie mal das Fenster aus Versehen schließen.

Wichtig: Im Hintergrund läuft SD als sogenannter Server in der Eingabeaufforderung. Dieses Fenster dürfen Sie nicht schließen, solange Sie SD für die Bildgenerierung nutzen.

Wenn Sie die Weboberfläche versehentlich schließen, können Sie sie jederzeit über http://127.0.0.1:7860 wieder aufrufen, solange der Server läuft.

Gehen Sie folgendermaßen vor:

- Wählen Sie das Basismodell aus. Wir empfehlen V1-5-pruned...

- Geben Sie eine Bildbeschreibung an. Zu Anfang können Sie es gerne mit einem kurzen Prompt versuchen, beispielsweise »astronaut in front of lunar module«. Beachten Sie bitte, dass nur englischsprachige Prompts erlaubt sind.

- Unter Negative prompt geben Sie unerwünschte Bildelemente ein. Dieses sehr praktische Feature bietet der Konkurrent DALL-E nicht.

- Betätigen Sie Generate.

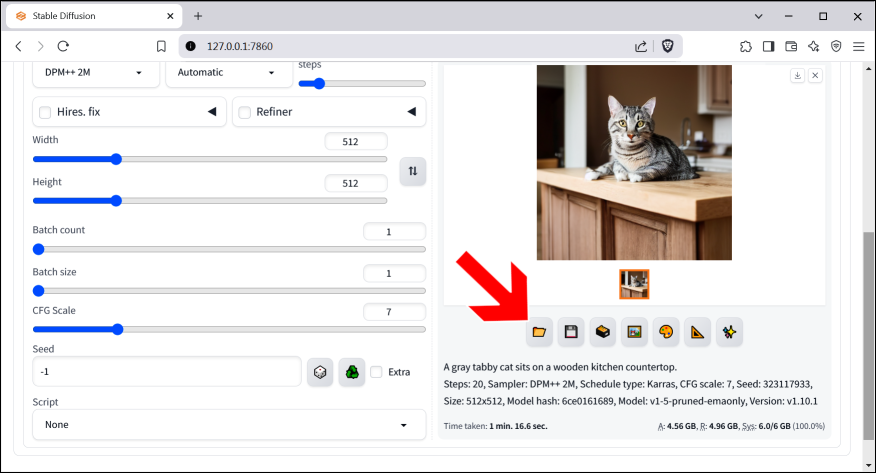

Unser Prompt lautete: »A gray tabby cat sits on a wooden kitchen countertop«

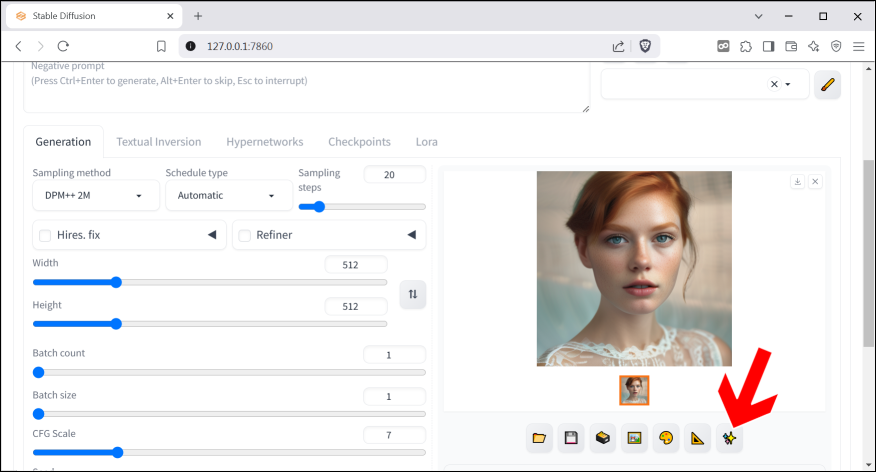

Die Schaltleisten:

: Öffnet das Bilderverzeichnis, in dem alle

generierten Bilder automatisch abgelegt werden.

: Öffnet das Bilderverzeichnis, in dem alle

generierten Bilder automatisch abgelegt werden. : Bild speichern.

: Bild speichern. : Zip-Datei mit den generierten Bildern speichern.

: Zip-Datei mit den generierten Bildern speichern. : Öffnet das Bild in img2img. Siehe Kapitel

Bilder nachbearbeiten (img2img).

: Öffnet das Bild in img2img. Siehe Kapitel

Bilder nachbearbeiten (img2img). : Bild im Inpaint-Register öffnen. Siehe Kapitel

Bilder nachbearbeiten (img2img).

: Bild im Inpaint-Register öffnen. Siehe Kapitel

Bilder nachbearbeiten (img2img). : Bild im Extras-Register öffnen. Siehe Kapitel

Bild hochskalieren.

: Bild im Extras-Register öffnen. Siehe Kapitel

Bild hochskalieren. : Bild hochskalieren. Siehe Kapitel Bild hochskalieren.

: Bild hochskalieren. Siehe Kapitel Bild hochskalieren.

Wenn Sie

oder

oder

betätigen, zeigt die Weboberfläche unter den

Schaltleisten jeweils einen Link an, nach dessen Anklicken Sie die

jeweilige Datei speichern können.

betätigen, zeigt die Weboberfläche unter den

Schaltleisten jeweils einen Link an, nach dessen Anklicken Sie die

jeweilige Datei speichern können.

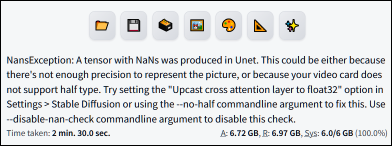

Falls kein Bild generiert wurde, überprüfen Sie, ob die Weboberfläche eine Fehlermeldung ausgeworfen hat. Diese finden Sie unterhalb der Stelle, an der das fertige Bild erscheinen sollte. Geben Sie die Fehlermeldung in Google ein, um eine mögliche Lösung für das Problem zu finden. In unserem Beispiel ist die Grafikkarte offenbar nicht leistungsfähig genug (»... or because your video card does not support half-type«).

Die Optionen

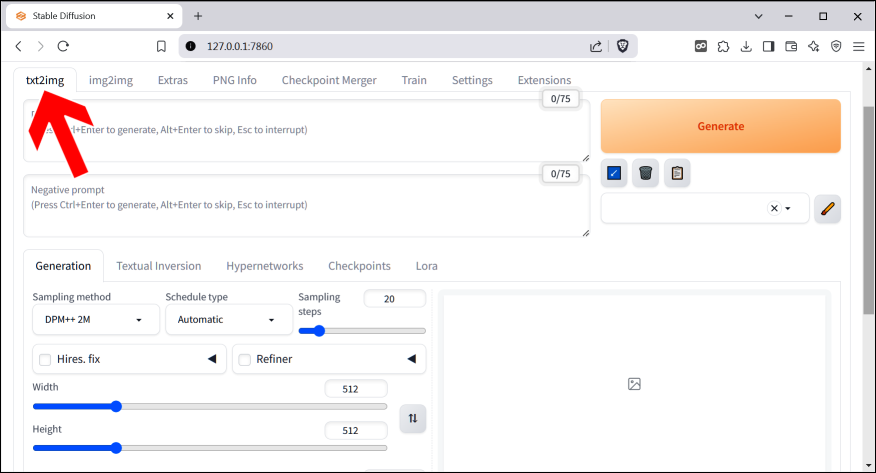

Über die Register am oberen Bildschirmrand (Pfeil) können Sie zwischen verschiedenen Optionen wechseln:

-

txt2img: Das Hauptregister, um Bilder basierend auf Texteingaben (Prompts) zu generieren. Hier legen Sie den gewünschten Bildinhalt, Stil und weitere Parameter fest.

-

Extras: Bietet zusätzliche Werkzeuge und Funktionen wie das Hochskalieren von Bildern (Vergrößern ohne Qualitätsverlust), die Wiederherstellung von deformierten Gesichtern in generierten Bildern und andere nützliche Bildbearbeitungsfunktionen.

-

PNG Info: Dient dazu, die Metadaten einer zuvor generierten PNG-Datei anzuzeigen. Diese Metadaten enthalten Informationen über die verwendeten Einstellungen, Prompts und Modelle, die zur Erstellung des Bildes verwendet wurden.

-

Checkpoint Merger: Ermöglicht das Zusammenführen (Mergen) verschiedener Stable Diffusion Modell-Dateien (Checkpoints) zu einem neuen, kombinierten Modell. Dies kann verwendet werden, um die Stärken verschiedener Modelle zu vereinen.

-

Train: Bietet Werkzeuge und Optionen zum Trainieren eigener Stable Diffusion Modelle oder zum Feinjustieren bestehender Modelle auf spezifische Datensätze oder Stile.

-

Settings: Hier können Sie verschiedene globale Einstellungen der AUTOMATIC1111 Web UI konfigurieren, wie zum Beispiel Pfade, Standardwerte, Optimierungen und Einstellungen für verschiedene Funktionen.

-

Extensions: Verwaltet die installierten Erweiterungen (Extensions) für die Web UI. Hier können Sie neue Erweiterungen installieren, bestehende aktivieren oder deaktivieren und deren Einstellungen verwalten, um die Funktionalität der Web UI zu erweitern.

Die Eingabefelder beziehungsweise Parameter im txt2img-Register gliedern sich in folgende Gruppen:

Prompteingabe

- Prompt: Hier geben Sie die detaillierte Beschreibung des gewünschten Bildes ein. Sie können Keywords, Stile, Künstler, Farben und mehr verwenden.

- Negative prompt:: Hier können Sie Begriffe eingeben, die im generierten Bild vermieden werden sollen (zum Beispiel »verschwommen«, »verzerrt«, »schlechte Qualität«).

Sampling-Einstellungen

- Sampling method: Wählt den Algorithmus aus, der zum Entrauschen des Bildes verwendet wird. Die verfügbaren Methoden liefern unterschiedliche Resultate und benötigen jeweils eine andere Berechnungsdauer.

- Schedule type: Diese Einstellung beeinflusst die Rauschreduktionskurve während des Bildgenerierungsprozesses. Die Rauschreduktionskurve bestimmt, wie das Rauschen in jedem Schritt des Sampling-Prozesses reduziert wird, was sich direkt auf die Bildqualität und den Stil der Ausgabe auswirken kann.

- Sampling Steps: Bestimmt, wie viele Schritte der Entrauschungsalgorithmus durchführt. Höhere Werte führen oft zu detaillierteren Bildern, benötigen aber mehr Zeit.

- Hires.fix: Diese Option wird verwendet, um ein Bild zunächst in einer niedrigeren Auflösung zu generieren und es anschließend hochzuskalieren, wobei gleichzeitig Details hinzugefügt oder korrigiert werden. Der Zweck ist, die typischen Artefakte oder Verzerrungen zu vermeiden, die bei der direkten Generierung von Bildern in sehr hoher Auflösung auftreten können.

- Refiner: Anwendung eines spezialisiertes Modells, um ein bereits generiertes Bild weiter zu verfeinern. Dieses Modell ist in der Regel darauf trainiert, bestimmte Details oder die allgemeine Qualität eines Bildes zu verbessern, nachdem die Hauptkomposition durch das ursprüngliche Modell erstellt wurde.

Bildgröße

- Width; Height: Legt die Breite und Höhe des generierten Bildes in Pixeln fest. Die Größe des Bildes, bestimmt durch Breite und Höhe, hat einen direkten Einfluss auf den benötigten Grafikspeicher (VRAM) Ihrer Grafikkarte. Größere Dimensionen erfordern mehr Rechenzeit und Speicher und können Fehler hervorrufen. Einige Modelle, die in Stable Diffusion verwendet werden, haben möglicherweise Einschränkungen hinsichtlich der maximalen Größe. Sehr große Werte können dann zu Fehlern oder suboptimalen Ergebnissen führen. Es empfiehlt sich daher ein Blick in die zugehörige Dokumentation des jeweils verwendeten Models hinsichtlich der Breite und Höhe. Funktionen wie Hires.fix oder andere Optionen sind eventuell darauf ausgelegt, Bilder bis zu einer bestimmten Größe optimal zu verarbeiten.

Batch-Optionen

- Batch Count: Gibt an, wie viele Bilder in einem Durchgang generiert werden sollen.

- Batch Size: Gibt an, wie viele Bilder gleichzeitig verarbeitet werden sollen (kann die Speicherauslastung beeinflussen).

Seed-Optionen

- CFG Scale (Classifier-Free Guidance Scale): Steuert, wie stark das generierte Bild dem Prompt folgt. Höhere Werte führen zu einer stärkeren Übereinstimmung, können aber auch zu unrealistischen Ergebnissen führen.

- Seed: Ein numerischer Wert, der den Zufallsgenerator für die Bildgenerierung initialisiert. Mit demselben Seed und denselben Einstellungen wird immer dasselbe Bild generiert. Ein Wert von -1 bedeutet, dass ein zufälliger Seed verwendet wird.

- Extra: Ermöglicht das Festlegen einer bestimmten Anzahl von Seeds, die generiert werden sollen.

Skripte

-

Ein Dropdown-Menü bietet verschiedene Skripte, die die Funktionalität der Web-Oberfläche erweitern. Dazu gehören beispielsweise Optionen für:

- Prompt matrix: Dieses Skript ermöglicht es Ihnen, eine Vielzahl von Bildern basierend auf Kombinationen verschiedener Prompts zu generieren. Stellen Sie es sich wie eine Tabelle vor: Sie definieren verschiedene Textbausteine oder Phrasen, die in Ihrem Prompt verwendet werden sollen. Das Skript kombiniert diese Bausteine systematisch miteinander und erzeugt für jede mögliche Kombination ein separates Bild.

- X/Y plot: Dieses Skript ist ein mächtiges Werkzeug, um systematisch zu untersuchen, wie sich verschiedene Parameter auf das generierte Bild auswirken. Es erzeugt eine Matrix von Bildern, bei der jede Achse (X, Y und optional Z) für eine Variation eines bestimmten Parameters steht. Sie wählen bis zu drei Parameter aus (zum Beispiel Sampling steps, CFG Scale, Seed, verschiedene Prompt-Bestandteile). Für jeden ausgewählten Parameter geben Sie eine Reihe von Werten an. Das Skript generiert dann eine Tabelle von Bildern, wobei jede Zelle der Tabelle einer bestimmten Kombination der gewählten Parameterwerte entspricht.

- Prompts from file oder Textbox: Dieses Skript ermöglicht es Ihnen, eine Liste von Prompts aus einer Textdatei oder direkt aus einem Textfeld in der Web UI zu verwenden. Sie können entweder eine Textdatei hochladen, in der jede Zeile einen separaten Prompt enthält oder Sie können mehrere Prompts direkt in ein Textfeld eingeben, wobei jeder Prompt durch eine neue Zeile getrennt wird. Das Skript generiert dann für jeden Prompt in der Liste ein einzelnes Bild. Es eignet sich sehr gut, um zuvor erstellte Prompt-Listen zu verwenden oder um verschiedene Ideen schnell zu testen.

Gutes Prompting

SD bietet das Potenzial für hochrealistische Bilder, erfordert aber im Vergleich zu DALL-E wesentlich präzisere Prompts, um hervorragende Ergebnisse zu erhalten.

SD verarbeitet zwar deutschsprachige Prompts, aber englische Prompts liefern in der Regel präzisere und detailliertere Bilder. Heutzutage ist es ohnehin mit den Übersetzungs-Tools von Google Translate (https://translate.google.de) oder DeepL (https://www.deepl.com) kein Problem, die Prompts zu übersetzen. In unseren folgenden Beschreibungen verwenden wir daher die englischen Begriffe.

Die Anatomie eines guten Prompts

- Subjekt: Beschreiben Sie klar und spezifisch das Hauptobjekt Ihres Bildes. Anstelle von »a dog« (»ein Hund«) verwenden Sie zum Beispiel »a golden retriever puppy playing in a sunflower field« (»ein goldener Retrieverwelpe, der auf einem Sonnenblumenfeld spielt«). Seien Sie so detailliert wie möglich, um der KI nicht zu viel Spielraum für eigene Interpretationen zu lassen. Geben Sie das Subjekt immer früh im Prompt an.

- Medium: Geben Sie die Art des Kunstwerks an, das Sie wünschen. Dies kann den Stil drastisch verändern. Beispiele sind: photography, oil painting, digital art, pencil drawing, illustration

- Stil: Beschreiben Sie den gewünschten künstlerischen Stil. Sie können allgemeine Begriffe, bestimmte Künstler oder Kunstströmungen erwähnen: surrealistic, impressionistic, cyberpunk, fantasy, in the style of Van Gogh, in the style of Salvador Dali, Art Nouveau, Pop Art

- Qualität und Detail: Verbessern Sie die gewünschte Qualität, indem Sie entsprechende Schlüsselwörter verwenden: high quality, detailed, sharp focus, masterpiece, elaborate, realistic, ultra-detailed, 4k

- Beleuchtung: Beschreiben Sie die Lichtverhältnisse, um Stimmung und Tiefe hinzuzufügen: soft light, rim light, golden hour, studio lighting, dramatic lighting

- Farbe: Geben Sie die gewünschten Farben oder Farbpaletten an: vibrant colors, iridescent gold, monochromatic

- Komposition: Leiten Sie die KI bei der Bildgestaltung an: close-up, wide-angle shot, full-body shot, portrait, landscape, top-down view

- Negative Prompts: Mit negativen Prompts können Sie angeben, was im Bild nicht erscheinen soll. Es ist schon etwas merkwürdig, dass man der KI wie einem Kind Anweisungen für Selbstverständlichkeiten gibt, aber die Ergebnisse lassen sich damit entscheidend verbessern: blurry, ugly, deformed, watermark, text, poor anatomy

Beispiel-Prompts

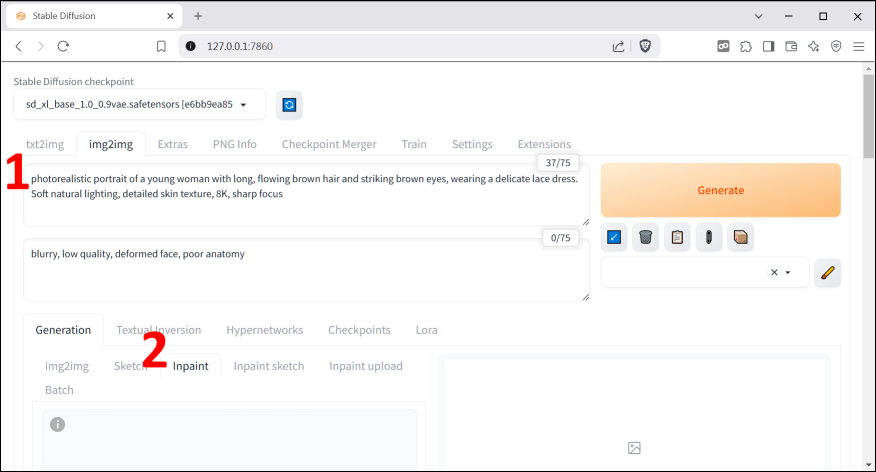

Fotorealistisches Porträt9

»A photorealistic portrait of a young woman with long, flowing blonde hair and striking blue eyes, wearing a delicate lace dress. Soft natural lighting, detailed skin texture, 8K, sharp focus«

Negativer prompt (Achtung, diesen ins Negative prompt-Feld eingeben!)

»blurry, low quality, deformed face, poor anatomy«

Eine Fantasy-Landschaft10

»A stunning fantasy landscape with giant, glowing mushrooms, a crystal clear river flowing through a lush forest, vibrant colors, dynamic lighting, ethereal atmosphere, artstation«

Negativer Prompt

»blurry, cartoonish, simple«

Cyberpunk-Charakter11

»A female cyberpunk cyborg with glowing neon accents, intricate mechanical details, wearing a futuristic black trench coat, standing in a rain-soaked city street at night, cinematic lighting, 8k«

Negativer Prompt

»blurry, low quality, organic, fleshy«

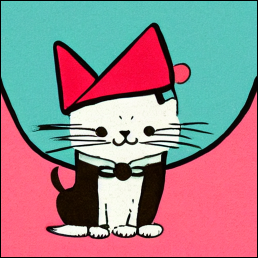

Stilisierte Illustration12

»A whimsical illustration of a cute cat with a tiny hat, illustration style of a children\'s book, soft pastel colors, simple background«

Negativer Prompt

- »photorealistic, detailed, complex background«*

Abstrakte Kunst13

»Abstract painting with swirling lines and vibrant colors, flowing shapes, high contrast, modern art«

Negativer Prompt

- »realistic, figurative, clear objects«*

Einige Websites, die Ihnen bei der Entwicklung von guten Prompts helfen:

Awesome Stable Diffusion Prompt (GitHub)

Sammlung von Prompts und Prompt-Beispielen für Stable Diffusion. Nutzer können die Prompts kombinieren und anpassen, um die gewünschten Ergebnisse zu erzielen.

https://github.com/yuyan124/awesome-stable-diffusion-prompts

Stable Diffusion Prompt Templates (GitHub)

Diese Seite bietet einfache Prompt-Vorlagen, die auch für andere Modelle wie Midjourney und DALL-E geeignet sind. Die Prompts sind von Discord-Servern und Websites gesammelt und modifiziert, um optimale Ergebnisse zu erzielen.

https://github.com/Dalabad/stable-diffusion-prompt-templates

Stable Diffusion Prompts

Diese Plattform bietet eine innovative Suchmaschine für AI-Prompts, die es ermöglicht, die besten Prompts für die Erstellung beeindruckender AI-Kunstwerke zu finden. Nutzer können nach Schlüsselwörtern, Stilen oder Modellen suchen.

https://stabledifffusion.com/prompts

Hier einige negative Prompts, die Sie an Ihre Bedürfnisse anpassen sollten.

Universeller negativer Prompt14:

bad anatomy, bad proportions, blurry, cloned face, cropped, deformed, disfigured, duplicate, error, extra arms, extra fingers, extra legs, extra limbs, fused fingers, gross proportions, jpeg artifacts, long neck, low quality, lowres, malformed limbs, missing arms, missing legs, morbid, mutated hands, mutation, mutilated, out of frame, poorly drawn face, poorly drawn hands, signature, text, too many fingers, ugly, username, watermark

Negativer Prompt für Landschaften:

blurry, boring, close-up, dark, details are low, distorted details, eerie, foggy, gloomy, grains, grainy, grayscale, homogenous, low contrast, low quality, lowres, macro, monochrome, multiple angles, multiple views, opaque, overexposed, oversaturated, plain, plain background, portrait, simple background, standard, surreal, unattractive, uncreative, underexposed

Negativer Prompt für Objekte:

absent parts, asymmetrical design, broken, cartoonish, cloned, collapsed, complex, distorted perspective, extra pieces, faded color, flawed shape, flipped, folded, improper proportion, incomplete, incorrect geometry, inverted, kitsch, low quality, low resolution, macabre, misaligned parts, misshapen, missing parts, mutated, off-center, out of focus, over-saturated color, overexposed, oversized, poorly rendered, replica, surreal, tilted, underexposed, unrealistic, upside down

Fortgeschrittenes Prompting

Diese Anleitungen sollten Sie durchgehen, sobald Sie etwas Erfahrung mit SD haben.

Keywort-Gewichtung

Um bestimmte Ergebnisse zu erreichen, müssen wir nicht nur die entsprechenden Keywords verwenden, sondern auch deren »Gewichtung« anpassen (unter »Keywords« verstehen wir in diesem Zusammenhang alle in einem Prompt verwendeten Wörter). Dies sollen einige Beispiele im Folgenden zeigen15.

»cat, spring in Munich, vibrant, joyful, warm atmosphere, cherry blossoms, soft sunlight, serene garden, lush greenery, butterflies, golden hour glow, whimsical, painterly style, by Thomas Kinkade, Alphonse Mucha, Norman Rockwell«

Wenn wir das Gewicht von cat erhöhen, erzeugt SD deutlicher hervorgehobene Katzen. Reduzieren wir das Gewicht, ergibt sich wiederum weniger »Katze« -- natürlich immer statistisch gesehen. Diese Technik können wir auch auf die anderen Wörter beziehungsweise Eigenschaften anwenden, beispielsweise auf den Stil oder die Beleuchtung der Szenerie.

Die Entwickler der AUTOMATIC1111-Oberfläche bieten zwei Optionen zur Gewichtung an:

- (Keyword) erhöht die Gewichtung um 1,1 und entspricht (Keyword: 1.1)

- ((Keyword)) entspricht (Keyword: 1.21)

- (((Keyword))) entspricht (Keyword: 1.33)

Umgekehrt reduzieren Sie die Gewichtung mit eckigen Klammern:

- [Keyword] entspricht (Keyword: 0.9)

- [[Keyword]] entspricht (Keyword: 0.81)

- [[[Keyword]]] entspricht (Keyword: 0.73)

Beachten Sie, dass hier das angelsächsische Zahlenformat mit Punkt statt Komma zum Einsatz kommt.

Tipp: In der Prompt-Eingabezeile erhöhen/reduzieren Sie das Gewicht von Wörtern mit Ctrl + Hoch/Runter-Cursortaste. Klicken Sie dazu vorher auf das Wort, dessen Gewicht Sie ändern möchten.

»(((cat))), spring in Munich, vibrant, joyful, warm atmosphere, cherry blossoms, soft sunlight, serene garden, lush greenery, (((butterflies))), golden hour glow, whimsical, painterly style, by Thomas Kinkade, Alphonse Mucha, Norman Rockwell«

Mit diesem Prompt machen wir die Katze(n) und Schmetterlinge zum Hauptmotiv.

Sie können auch zwei Keywords mischen.

Die Syntax dafür ist: [Keyword1:Keyword2:Faktor].

Faktor kontroliert, nach welchem Schritt in der Bildgenerierung von keyword1 nach keyword2 gewechselt wird. Es sind Werte zwischen 0 und 1 möglich.

Beachten Sie, dass Keyword1 die globale Bildkomposition bestimmt. Dies liegt an der grundsätzlichen Funktionsweise von SD, das, vereinfach gesagt, aus einem Bildrauschen nach und nach die Details entwickelt.

»[Johann Sebastian Bach:Wolfgang Amadeus Mozart:0.5]«

Das erzeugte Portrait besteht jeweils zur Hälfte aus den Gesichtern der beiden Musiker.

Beachten Sie bei Experimenten, dass im Prompt erwähnte Personen möglicherweise nicht im KI-Modell enthalten sind. Die KI nutzt dann zufällig erzeugte Charaktäre.

Bei Bedarf probieren Sie ein anderes KI-Modell aus (siehe Kapitel Installation von Modellen).

Konsistente Gesichter

SD erzeugt jedesmal ein komplett anderes Bild, wenn Sie die Generierung anstoßen. Es gibt natürlich auch Umstände, die nach konsistenten Gesichtern verlangen, beispielsweise für Comics oder Buchillustrationen16.

Die meisten Basismodelle enthalten auch Bilddaten von Stars (Schauspieler, Musiker, Sportler usw.) und anderen Persönlichkeiten. Dies können wir uns zunutze machen:

»Emma Watson, photo of young woman, highlight hair, sitting outside restaurant, wearing dress, studio lighting, looking at the camera, sharp focus, highly detailed glossy eyes, highly detailed skin«

Negativer Prompt: »disfigured, ugly, bad, immature, cartoon, anime, 3d, painting, b&w«

Wie Sie bei eigenen Versuchen feststellen werden, wird nun immer das gleiche Gesicht -- von der Schauspielerin -- erzeugt, nur die Szenerie ändert sich.

Wenn Sie ein gleichbleibendes Gesicht kreieren möchten, das keine Ähnlichkeit mit einem Prominenten hat, kombinieren Sie einfach mehrere Personen, beispielsweise Emma Watson mit ihren Filmkolleginnen Alicia Vikander und Cara Delevingne. Das ist leicht erledigt. Es ist ratsam, innerhalb derselben Altersgruppe zu bleiben, um inkonsistente Altersdarstellungen zu vermeiden.

»Emma Watson, Alicia Vikander, Cara Delevingne, photo of young woman, highlight hair, sitting outside restaurant, wearing dress, studio lighting, looking at the camera, sharp focus, highly detailed glossy eyes, highly detailed skin«

Negativer Prompt

»disfigured, ugly, bad, immature, cartoon, anime, 3d, painting, b&w«

Es zeigt sich aber ein Problem: Emma Watson ist aufgrund ihrer erfolgreichen Karriere im Vergleich zu den anderen Personen überproportional mit Ihren Bilddaten in den Basismodellen vertreten. Wir müssen deshalb die Gewichtungen anpassen, damit die Frau in den generierten Bilder nicht immer genau wie Emma Watson aussieht.

»(Emma Watson:0.5), (Alicia Vikander:1.1), (Cara Delevingne:1.1), photo of young woman, highlight hair, sitting outside restaurant, wearing dress, studio lighting, looking at the camera, sharp focus, highly detailed glossy eyes, highly detailed skin«

Negativer Prompt

»disfigured, ugly, bad, immature, cartoon, anime, 3d, painting, b&w«

Probieren Sie unterschiedliche Gewichtungen aus, bis das Wunschgesicht erreicht ist. Bei Bedarf können Sie auch im negativen Prompt bestimmte Eigenschaften ausschließen.

Keywords testen

Bei den meisten Basismodellen ist nicht klar, mit welchen Bildern sie trainiert wurden Das betrifft vor allem die künstlerischen Stile. Wenn Sie wissen möchten, ob ein Künstler in einem Basismodell vertreten ist, geben Sie nur dessen Name ein und generieren einige Bilder.

»Pablo Picasso«

ist offenbar im Basismodell V1.5 vertreten.

Vermeiden Sie Künstler/Kunststile in ihren Prompts, die nicht im Basismodell vorhanden sind.

Assoziationen

Einige von Ihnen in den Prompts verwendete Attribute sind stark korrelierend, das heißt, sie bringen weitere Eigenschaften mit. Wenn Sie zum Beispiel eine »Frau mit blauen Augen« im Prompt angeben, erhalten Sie meistens eine weiße, westlich gekleidete Frau. Bei »Frau mit braunen Augen« erhalten Sie dagegen eine größere Varietät mit Frauen verschiedener Ethnizitäten. Den in den Basismodellen vorhandenen Bias sollte man immer im Auge behalten.

»A young female with brown eyes, sitting outside restaurant«

»A young female with blue eyes, sitting outside restaurant«

Ein ähnliches Problem tritt auf, wenn Sie im Prompt Künstler angeben, deren Werk einen bestimmten Stil hat:

»beautiful girl with ginger hair, digital painting by Alphonse Mucha«

Der Stil des Malers Alphonse Mucha wird beispielsweise aufgrund seiner interessanten Übertreibungen und Stilvermischungen gerne genutzt. Man sollte sich aber bewusst sein, dass Mucha eine große Vorliebe für Umrahmungen hatte, die sich leider auch in den generierten Bildern wiederspiegeln.

Installation von Modellen

Die für SD benötigte Intelligenz steckt in den sogenannten Basismodellen, die das »Kernwissen« zur Generierung von Bildern in einem bestimmten Stil enthalten17. Die Basismodelle wurden mit unterschiedlichen Datensätzen trainiert, was zu Variationen im Stil und den Arten von Bildern führt, die sie erzeugen können18 19.

Die beliebtesten Basismodelle sind:

- Stable Diffusion v1.5 (bei Ihnen bereits vorinstalliert)

- Stable Diffusion XL (SDXL)

- Flux.1 dev

Das Training eines Basismodells ist extrem aufwendig und teuer. Alle anderen Modelle basieren deswegen auf einem der Basismodelle, das einem weiterem Training mit Genre-spezifischen Bildern unterworfen wurde. Ein Modell, das beispielsweise auf Manga-Bildern trainiert wurde, wird standardmäßig äußerst präzise Bilder im Manga-Stil erzeugen.

Wie die von SD generierten Bilder aussehen, hängt nicht nur vom Prompt, sondern in sehr hohem Maße vom ausgewählten Basismodell (KI-Modell) ab, das mit bestimmten Bildtypen trainiert wurde. Es empfiehlt sich zu Anfang ein allgemeines Modell wie SD V1.5 zu nutzen, damit man die Wirkungsweise der eigenen Text-Prompts besser nachvollziehen kann.

Die Basismodelle V1.5 und SDXL sind für ihre Anfängerfreundlichkeit bekannt und liefern auch mit einfachen Texteingaben gute Ergebnisse20. Wir empfehlen den Start mit diesen beiden Modellen, für die es viele Anleitungen und Inspirationen im Internet gibt.

Beachten Sie, dass einige Basismodelle höhere Hardware-Anforderungen haben. Das bei SD standardmäßig vorinstallierte Modell Stable Diffusion v1.5 hat beispielsweise geringere VRAM-Anforderungen als SDXL und ist daher für Benutzer mit älteren oder weniger leistungsstarken Grafikkarten empfehlenswerter.

Die Besonderheiten der beiden Modelle:

Stable Diffusion v1.5: Ein breit genutztes Allzweckmodell

- Relativ geringere Hardware-Anforderungen: Im Vergleich zu neueren Modellen wie SDXL hat v1.5 im Allgemeinen geringere VRAM-Anforderungen. Als Minimum reichen 4 GB VRAM der Grafikkarte aus. Dies macht es zu einer guten Option für Benutzer, die eine ältere beziehungsweise weniger leistungsfähigere Grafikkarte einsetzen.

- Fülle an feinabgestimmten Modellen und LoRAs: Die Reife von v1.5 bedeutet ein riesiges Ökosystem an benutzerdefinierten Checkpoints (feinabgestimmten Modellen) und LoRAs (kleineren Patch-Dateien zur Modifizierung von Stilen), die für verschiedene spezifische Stile und Themen existieren. Dies ermöglicht es Anfängern, relativ einfach spezialisierte Modelle für bestimmte Arten von Bildern zu finden und zu verwenden, zum Beispiel für Anime- oder fotorealistische Stile.

- Qualitätseinschränkungen: Das inzwischen in die Jahre gekommene v1.5-Modell liefert nur Bilder mit einer Auflösung von 512×512 Pixeln. Zwar lassen sich die Bilder nachträglich hochskalieren, nur sind sie dann nicht so scharf und detailiert wie bei Modellen mit höherer nativer Auflösung. Das macht sich besonders bei Gesichtern bemerkbar, die of teigig aussehen (»Uncanny Valley«).

- Komplexität der Texteingabe: Das Erzielen der gewünschten Ergebnisse erfordert manchmal detailliertere und spezifischere Texteingaben im Vergleich zum SDXL-Modell. Anfänger haben daher eine höhere Lernkurve.

Stable Diffusion XL (SDXL): Die nächste Generation

- Überblick: Die höhere native Auflösung von 1024×1024 Pixeln ermöglicht detailliertere und schärfere Bilder mit hohem Dynamikumfang. Im Gegensatz zu anderen Modellen wird auch die Erstellung von Beschriftungen unterstützt. Auch komplexere und nuanciertere Text-Prompts werden von dem Modell sehr gut interpretiert.

- Anfängerfreundlich: SDXL erzeugt selbst aus einfacheren und kürzeren Texteingaben im Vergleich zu v1.5 bessere Ergebnisse. Es werden auch weniger sogenannte negative Prompts benötigt, um unerwünschte Elemente in den generierten Bild zu vermeiden.

- Höhere Hardware-Anforderungen: SDXL benötigt im Allgemeinen mehr GPU-VRAM als v1.5. Zwar funktioniert die Generierung bereits mit 8 GB VRAM, wenn man zusätzliche Optionen nutzt, können aber auch mindestens 12 GB VRAM nötig sein.

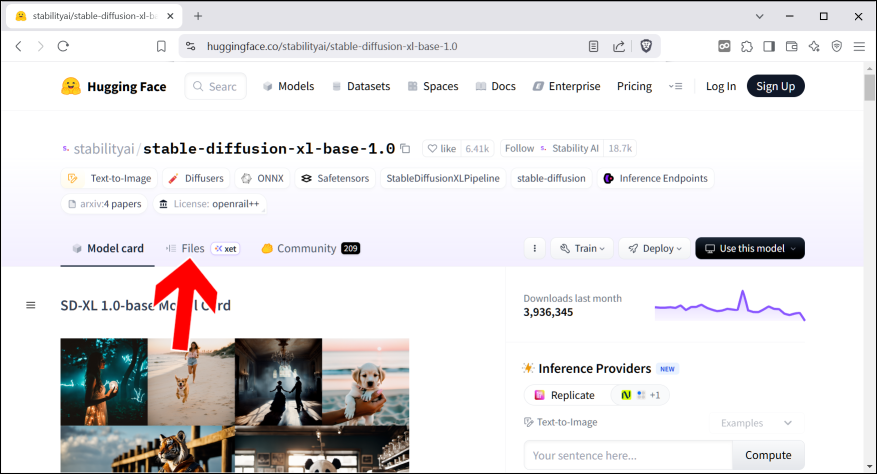

Die Basismodelle finden Sie auf der Hugging Face-Website. Das Basismodell Stable Diffusion v1.5 ist, wie bereits erwähnt, bei Ihnen bereits vorinstalliert. Wir laden deshalb nun SDXL herunter.

Rufen Sie https://huggingface.co/stabilityai/stable-diffusion-xl-base-1.0 auf.

Aktivieren Sie mit einem Klick das Files-Register.

Sie benötigen eine Datei mit der Endung ».safetensors«. Hier gibt davon aber zwei: »d_xl_base_1.0_0.9vae.safetensors« und »sd_xl_base_1.0.safetensors«. Der Unterschied zwischen beiden liegt darin, dass bei der ersten Datei mit »vae« im Namen bereits ein Variational Autoencoder (VAE) enthalten ist. Dieser spielt für die Bildqualität und Details eine zentrale Rolle und ist besonders einsteigerfreundlich.

Klicken Sie daher auf die Datei »sd_xl_base_1.0_0.9vae.safetensors«.

Falls Sie unsicher sind, ob Sie die richtige Datei vor sich haben, halten Sie einfach den Mauszeiger darauf und der Webbrowser zeigt am unteren Fensterrand den vollen Dateinamen an.

Die download-Schaltleiste finden Sie unten auf der Webseite (Pfeil).

Kopieren Sie die herunterladenen Basismodelle in das Verzeichnis C:\stable-diffusion\stable-diffusion-webui\models\Stable-diffusion.

Ein Klick auf

(Pfeil) aktualisiert die Modell-Liste. Wählen

Sie danach ein Modell aus, worauf die Initialisierung einige Sekunden in

Anspruch nimmt.

(Pfeil) aktualisiert die Modell-Liste. Wählen

Sie danach ein Modell aus, worauf die Initialisierung einige Sekunden in

Anspruch nimmt.

Es gibt tausende Modelle, von denen wir Ihnen einige vorstellen möchten21:

- Realistic Vision: Erzeugt realistische Szenen. Download: https://civitai.com/api/download/models/29460

- DreamShaper: Auf einen Portrait-Illustrationsstil abgestimmt, der fotorealistische Elemente mit Computergrafiken kombiniert. Download: https://civitai.com/api/download/models/5636?type=Pruned%20Model&format=SafeTensor

- Juggernaut XL: Es erzeugte aber realistischere Fotos und kann SDXL gut ersetzen. Download: https://civitai.com/models/133005

- Pony Diffusion: Für Liebhaber von Anime und Cartoons und Fantasy-Szenen. Download: https://civitai.com/models/257749/pony-diffusion-v6-xl

- Deliberate v2: Erzeugt erstaunlich realistische Bilder. Download: https://huggingface.co/XpucT/Deliberate/blob/main/Deliberate_v2.safetensors (auf download klicken)

- F222: Das Modell wurde ursprünglich für die Generierung von Aktfotos entwickelt. Weil es anatomisch korrekte Bilder generiert, eignet es sich ausgezeichnet für realistische Frauenportraits. Download: https://huggingface.co/acheong08/f222/blob/main/f222.ckpt (auf download klicken)

- Protogen v2.2 (Anime): Erzeugt geschmackvolle Bilder im Anime-Stil. Download: https://civitai.com/api/download/models/4007

- GhostMix: Trainiert mit Bildern im Stil der Ghost in the Shell-Mangas. Erzeugt Cyborgs und Roboter. Download: https://civitai.com/api/download/models/59685

- Waifu-diffusion: Bei Waifu handelt es sich um die »Anbetung« bestimmter weiblicher Anime-Figuren22. Das Model generiert entsprechende Bilder. Download: https://huggingface.co/hakurei/waifu-diffusion (auf download klicken)

Weitere Funktionen

Die im folgenden beschriebenen Funktionen sollten Sie erst ausprobieren, wenn einige bereits einige Zeit mit SD gearbeitet haben beziehungsweised dessen Funktionsweise verstanden haben.

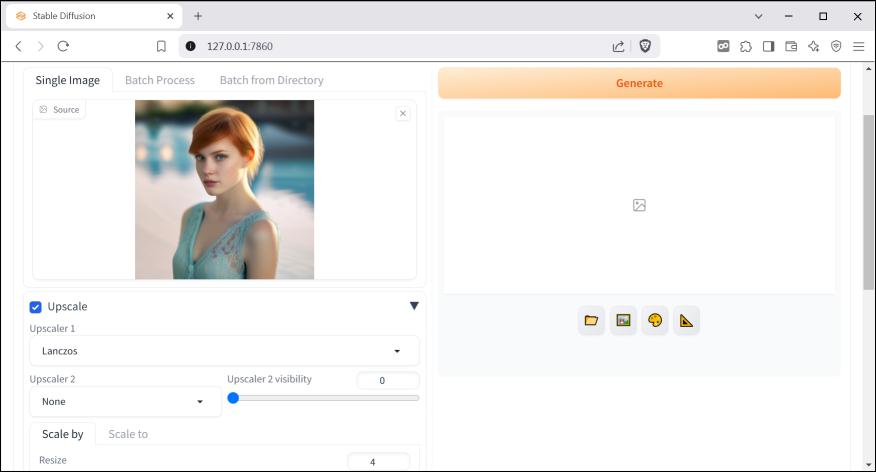

Bild hochskalieren

SD erzeugt standardmäßig Bilder in einer Auflösung von 512×512 Pixeln. Sie können über die Regler natürlich auch andere Werte wie 1600×1200 einstellen, falls Sie Ihre Bilder beispielsweise später ausdrucken möchten.

Es gibt jedoch mehrere Gründe, warum es oft besser ist, in SD ein Bild nachträglich hochzuskalieren, anstatt direkt in hoher Auflösung zu generieren23 24:

Zeit- und Ressourceneffizienz

Die Generierung von Bildern in hoher Auflösung benötigt deutlich mehr Rechenzeit im Vergleich zu niedrigeren Auflösungen. Statt ein einzelnes hochauflösendes Bild zu erzeugen, kann man in der gleichen Zeit mehrere Varianten in niedriger Auflösung (standardmäßig 512×512 Pixel) generieren und dann das beste Ergebnis für die Hochskalierung auswählen.

Qualitätsvorteile

Moderne KI-basierte Upscaler können beeindruckende Details hinzufügen, die bei direkter Generierung in hoher Auflösung möglicherweise nicht entstehen würden. Besonders LDSR (Latent Diffusion Super Resolution) und andere spezialisierte Upscaler können feinere Details erzeugen und Unschärfe reduzieren.

Ein Klick auf

berechnet das Bild mit doppelter Auflösung neu.

Es kommen viele Bilddetails dazu.

berechnet das Bild mit doppelter Auflösung neu.

Es kommen viele Bilddetails dazu.

Sie möchten die Vergrößerung selbst bestimmen? Dann klicken Sie auf

, was das Extras-Register öffnet.

, was das Extras-Register öffnet.

Die Bildskalierung erfordert ein präzises Verständnis der verfügbaren Parameter im Extras-Register, um qualitativ hochwertige Ergebnisse zu erzielen. Stellen Sie die unten vorgestellten Parameter ein und betätigen Sie Generate.

Upscaler-Auswahl und Modellkombinationen

Die Wahl des Upscalers bestimmt maßgeblich die Detailtreue des skalierten Bildes. ESRGAN_4x und R-ESRGAN 4x+ liefern hier sehr gute Ergebnisse25 26. Spezialisierte Modelle wie UltraSharp oder LDSR (Latent Diffusion Super-Resolution) eignen sich hingegen eher für künstlerische Stile, indem sie Details hervorheben.

Auch die Kombination mit einem zweiten Upscaler über den Upscaler 2-Parameter ist möglich. Probieren Sie mal ESRGAN_4x für den Upscaler (berechnet die Mikrostrukturen) und SwinIR_4x für makroskopische Glättung aus. Tests haben gezeigt, dass ein Upscaler 2 visibility-Wert von 0,2--0,5 optimale Ergebnisse liefert27.

Skalierungsfaktor

Stellen Sie den gewünschten Skalierungsfaktor ein. Übliche Werte sind 2× oder 4×, je nachdem, wie stark Sie das Bild vergrößern möchten. Beachten Sie, dass Werte über ca. 6× zu Artefakten führen und daher keinen Sinn machen.

Gesichtsrestaurierung

GFPGAN und CodeFormer verbessern Gesichtsdetails.

- GFPGAN: Reduziert Rauschen, verbessert Hauttexturen und Haarkonturen.

- CodeFormer: Ähnlich GFPGAN, empfohlen bei stark verschobenen Gesichtspartien. Die Weight-Einstellung steuert die Balance zwischen Realismus/Abstraktion: 0.7-0.8 ist optimal für natürliche Hauttöne, \<0.5 für künstlerische Stilisierung.

Bildaufteilung und Vorverarbeitung

- Split oversized: Zerlegt Großbilder in 512x512-Tiles für VRAM-optimierte Verarbeitung.

- Auto focal point crop: Identifiziert Hauptobjekt (zum Beispiel Gesicht) für gezielte Bearbeitung. Wird mit Auto-sized crop für die automatische Erzeugung eines 1:1-Ausschnitts verwendet28.

Datensatz-Optimierung

- Create flipped copies: Bildverbesserung durch Verdoppeln der Trainingsdaten. Nicht bei Gesichtern verwenden. Nur für Objekte/Abstraktes empfohlen.

- Caption: Erzeugt strukturierte Prompt-Vorschläge als Textdatei. Sie finden diese im Verzeichnis C:\stable-diffusion\stable-diffusion-webui\outputs\extras-images.

Beispiel für eine von Caption erzeugte Bildbeschreibung:

1girl, 3d, blonde hair, blue eyes, blurry, blurry background, blurry foreground, bokeh, breasts, closed mouth, depth of field, eyelashes, lips, looking at viewer, motion blur, nose, photo \(medium\), photorealistic, realistic, short hair, sleeveless, solo, upper body

Bilder nachbearbeiten (img2img)

Im img2img-Register von SD können Sie Bildteile über sogenanntes Inpainting modifizieren oder durch Outpaiting über seine ursprünglichen Dimensionen hinaus erweitern.

Sie können zur Bildnachbearbeitung auf zwei Wegen wechseln: Entweder

aktivieren Sie das img2img-Register in der Benutzeroberfläche, oder

Sie klicken auf

, um ein gerade generiertes Bild

nachzubearbeiten.

, um ein gerade generiertes Bild

nachzubearbeiten.

- Passen Sie den Prompt an. In unserem Fall möchten wir doch lieber braunes Haar und braune Augen.

- Aktivieren Sie das Inpaint-Register.

Führen Sie nun die Änderungen im Prompt durch, zum Beispiel, indem Sie eine andere Farbe der Lippen, Augen oder Haare eingeben.

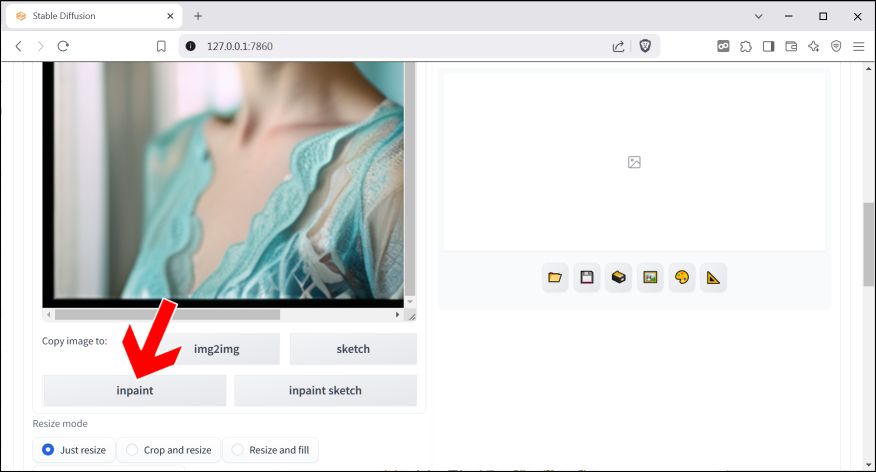

Klicken Sie unter Copy image to auf Inpaint.

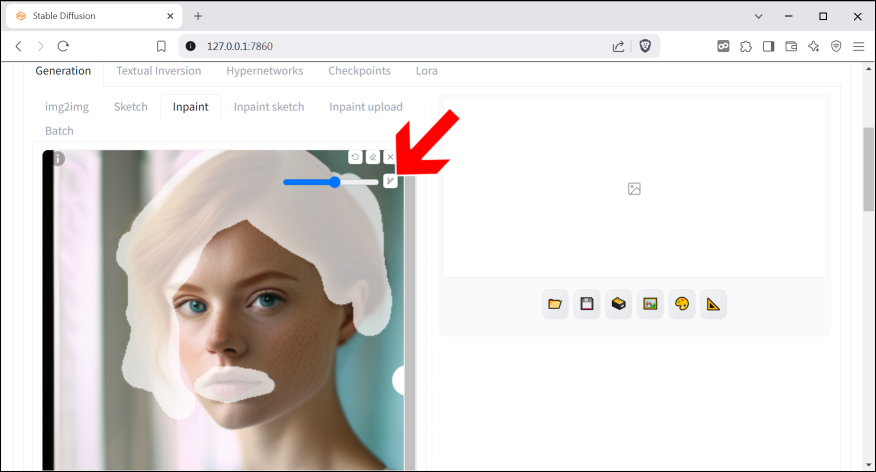

Klicken Sie auf

und wählen Sie eine Pinselstärke aus.

und wählen Sie eine Pinselstärke aus.

Dann malen Sie die Bereiche aus, die zu ändern sind, was auch als

»maskieren« bezeichnet wird. Falls Sie sich mal vertan haben, setzt

die Änderungen zurück. Anschließend klicken Sie auf

Generate, worauf ein Bild mit den Änderungen erzeugt wird. Falls Ihnen

das Egebnis nicht gefällt, erzeugen Sie einfach ein weiteres Bild.

die Änderungen zurück. Anschließend klicken Sie auf

Generate, worauf ein Bild mit den Änderungen erzeugt wird. Falls Ihnen

das Egebnis nicht gefällt, erzeugen Sie einfach ein weiteres Bild.

Links sehen Sie das Original, rechts das Ergebnis nach der Inpaint-Änderung.

Inpaint Sketch

Inpaint Sketch ermöglicht es, bestimmte Bereiche eines Bildes zu verändern, wobei die Farbe der markierten Zone einen starken Einfluss auf das Ergebnis hat. Im Gegensatz zum normalen Inpainting folgt Inpaint Sketch der Maske sehr genau und kann zu Verformungen führen, wenn die Skizze nicht präzise ist29.

Hauptunterschiede:

- Inpaint Sketch ändert die Farbe der Zone, die inpainted wird. Der Bereich wird unscharf gemacht und dann basierend auf den eingestellten Parametern neu erstellt.

- Bei Inpaint Sketch beeinflussen die Farben in der Maske das Ergebnis stark, während normales Inpainting die Farbe der Maske ignoriert.

- Inpaint Sketch folgt dem Umriss der Skizze genauer, was zu Verzerrungen führen kann, wenn die Skizze nicht präzise ist.

- Inpaint Sketch kann eine »farbige Spur« an Stellen hinterlassen, an denen kein neuer Inhalt generiert wurde.

Mit der Inpaint Sketch-Funktion können Sie ein bestehendes Motiv mit neuen Elementen erweitern30.

Haftungshinweis

Die Informationen im Blog wurden mit größter Sorgfalt erarbeitet und zusammengestellt. Dennoch können Fehler nicht vollständig ausgeschlossen werden. Verlag und Autor übernehmen daher keine juristische Verantwortung oder irgendeine Haftung für eventuell verbliebene Fehler oder deren Folgen. Alle erwähnten Warennamen und Bezeichnungen werden ohne Gewährleistung der freien Verwendbarkeit benutzt und sind möglicherweise eingetragene Warenzeichen.

Alle Rechte vorbehalten. Das Werk einschließlich aller Teile ist urheberrechtlich geschützt. Kein Teil darf ohne schriftliche Genehmigung durch den Autor Rainer Gievers, Borgentreich, reproduziert oder unter Verwendung elektronischer Systeme verarbeitet, vervielfältigt oder verbreitet werden.

-

https://de.wikipedia.org/wiki/Stable_Diffusion

-

https://www.nextdiffusion.ai/tutorials/how-to-install-stable-diffusion-on-windows

-

https://huggingface.co/docs/diffusers/v0.12.0/en/stable_diffusion

-

https://www.stablediffusiontutorials.com/2024/01/run-stable-diffusion-on-amd-gpu.html

-

https://diffusion-news.org/stable-diffusion-local-installation

-

https://www.youtube.com/watch?v=Y_xT08sqIho

-

https://www.nextdiffusion.ai/tutorials/how-to-install-stable-diffusion-on-windows

-

https://stable-diffusion-art.com/install-windows/

-

Inspiriert von: https://prompthero.com/stable-diffusion--1.5-prompts

-

Inspiriert von: https://prompthero.com/stable-diffusion-prompts

-

Inspiriert von: https://prompthero.com/stable-diffusion-prompts

-

Inspiriert von: https://sketchbooky.wordpress.com/2023/12/24/on-reading-the-official-stable-diffusion-1-5-prompt-guide/

-

Inspiriert von: https://prompthero.com/stable-diffusion--1.5-prompts

-

https://weam.ai/blog/imageprompt/what-is-negative-prompt-in-stable-diffusion/

-

https://stable-diffusion-art.com/prompt-guide/#Prompting_techniques

-

https://stable-diffusion-art.com/consistent-face/

-

https://stable-diffusion-art.com/models/

-

https://wiki.civitai.com/wiki/Model

-

https://www.youtube.com/watch?v=Po-ykkCLE6M

-

https://journeyaiart.com/blog-Which-Should-You-Choose-Stable-Diffusion-15-or-SDXL-27824

-

https://stable-diffusion-art.com/models/

-

https://lifeswire.de/waifu/ ↩

-

https://writingpeterkaptein.wordpress.com/2023/07/09/upscaling-images-using-txt2img-in-stable-diffusion/

-

https://www.aiarty.com/stable-diffusion-guide/ldsr-upscaler-stable-diffusion.htm

-

https://stable-diffusion-art.com/ai-upscaler/

-

https://www.youtube.com/watch?v=lTCB3oDnYrI

-

https://github.com/AUTOMATIC1111/stable-diffusion-webui/discussions/3749

-

https://myaiforce.com/text-inversion/ ↩

-

https://www.reddit.com/r/StableDiffusion/comments/10w52ax/inpaint_vs_inpaint_sketch/?tl=de

-

https://turboflip.de/design-experiments-with-inpaint-sketch-a1111/